概览

我想绝大多数人目前都是通过 chatGPT 或者 Copilot 这样的在线服务开始接触 AI ,但是使用在线服务,或多或少都会有隐私上的一些疑虑,所以如果能将这些 AI 模型放到本地运行,能够放心不少。

现在是 2024 年,距离 ChatGPT 发布已经过去快两年了。

早些年,如果你想玩 AI,难免会需要进行一些硬核的操作,比如找到相关的运行库,搭建 API 服务器,研究显卡驱动的兼容性,等等各种麻烦的关卡都摆在你面前。但是现在, 借由 AI 相关生态的丰富,在运本地运行 AI 模型进行推理,也变得异常简单。今天我想大家介绍一下,作为一个普通人,如何轻松搭上 AI 的末班车。

相信大家也注意到很多厂商今年都开始发力 AI 本地推理。这里就需要说一下简单 AI 相关的一些名词,以便大家进行本文的后续理解。

AI 模型:AI 模型相当于人的大脑,我们通过 GPU 对指定类型数据集(可以是聊天内容,百科,图片等等)进行运算,产生一种互相关联的特定结果,这就是 AI 模型。

推理或训练:本文涉及的内容指的是 AI 模型的 推理,指的是利用已成型的 AI 模型对某些问题进行处理,从而快速获得特定问题的处理结果。而训练是生成 AI 模型的操作,本文不讨论它。

模型参数:数据规模,以 B 作为计量单位,可以看到某些模型名称中带有 4B, 7B, 32B 110B 等。如果把 AI 模型理解为人的大脑的话,那么用于生成 AI 模型的那些数据,则可以说是 人生的一点点经验, 因此 7B 的模型通常会比 4B 的模型更聪明,能给出更好的答案。

对于普通用户来说

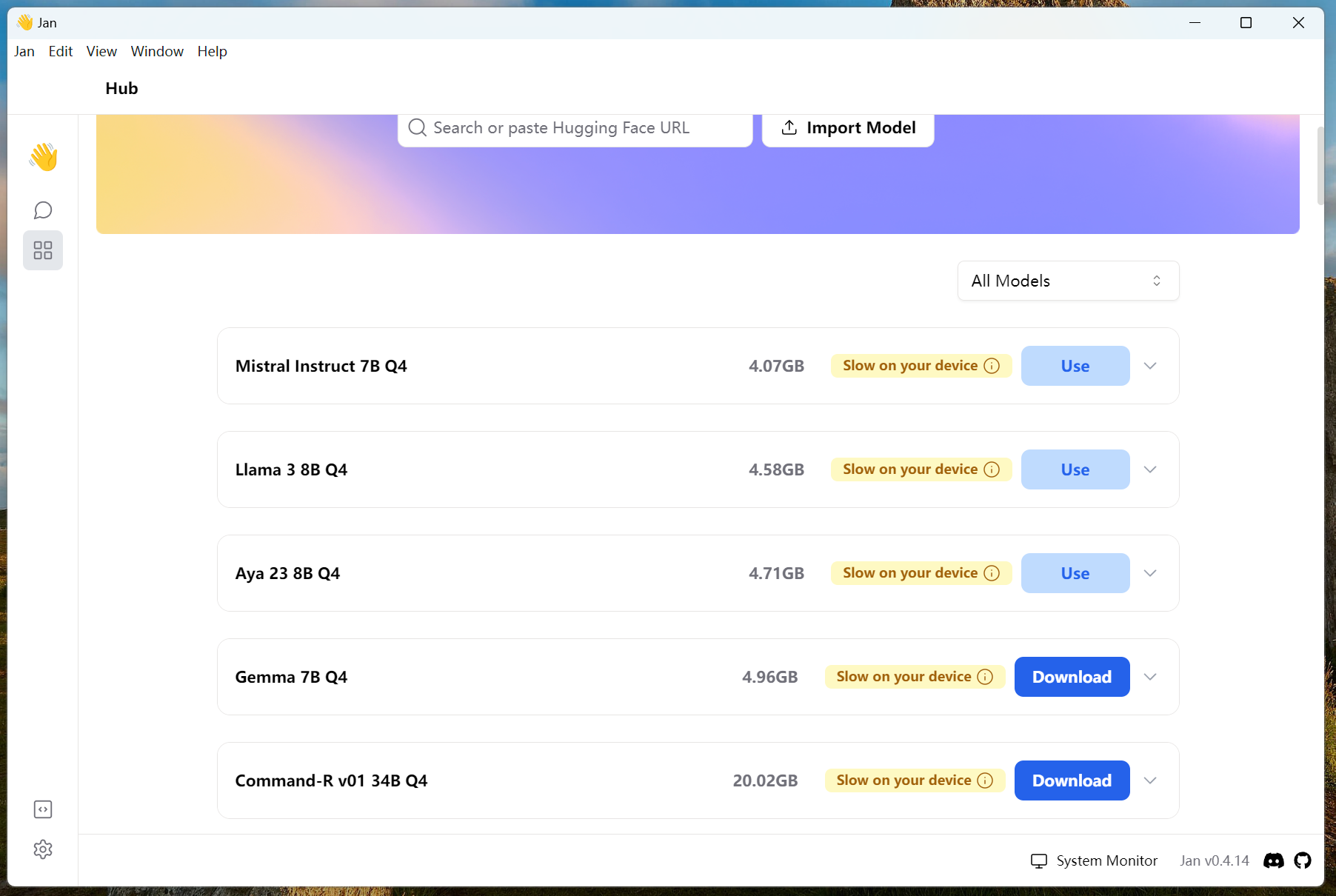

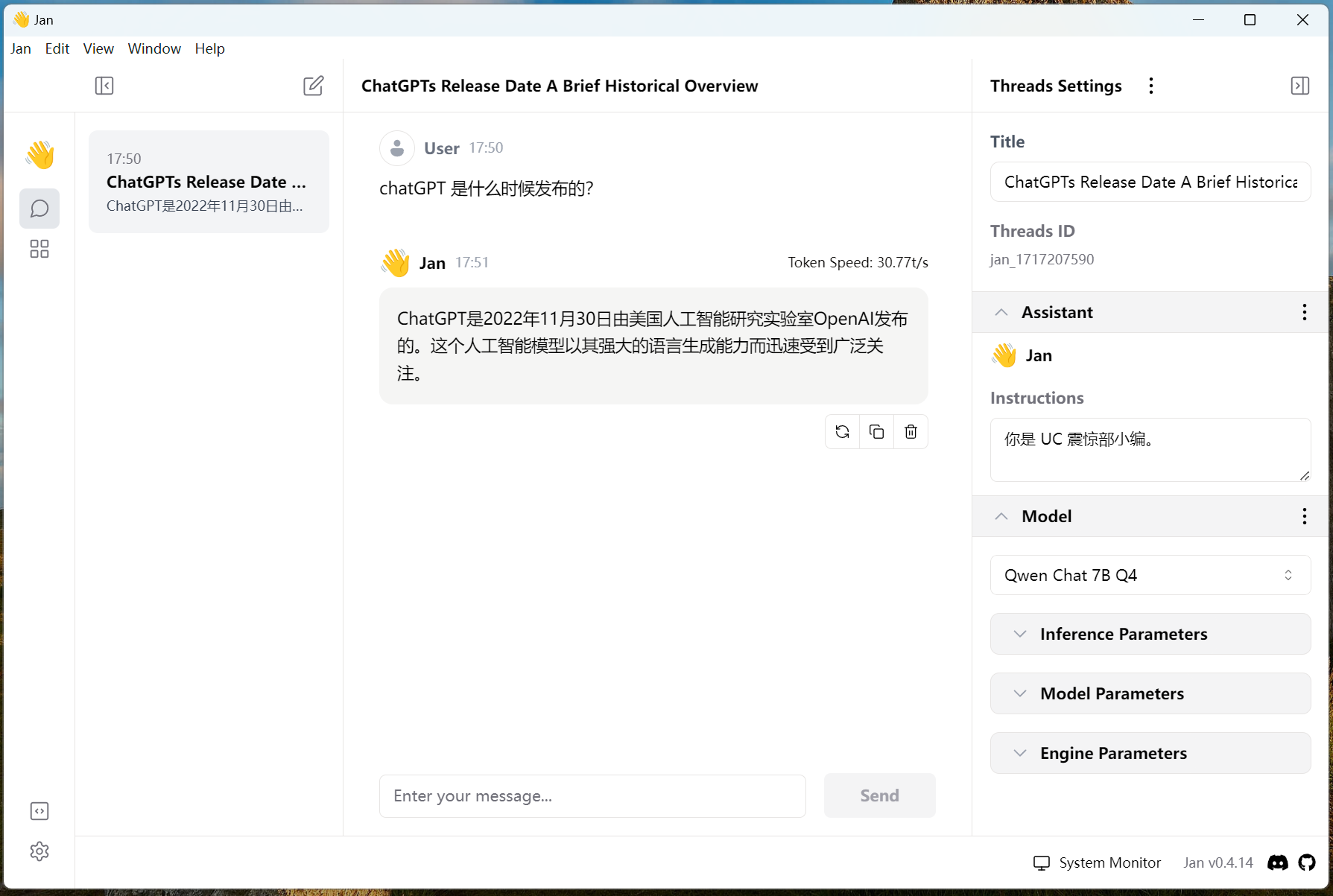

目前我觉得最好用的客户端是 Jan.ai ,这个软件操作简单,同时内置了远程 API。不过我们这里主要讨论的还是它的本地 AI 推理功能。

jan.ai 官网

到钛盘下载客户端

直接在软件内部下载 AI 模型

实机运行效果

对于想要折腾的一般程序员

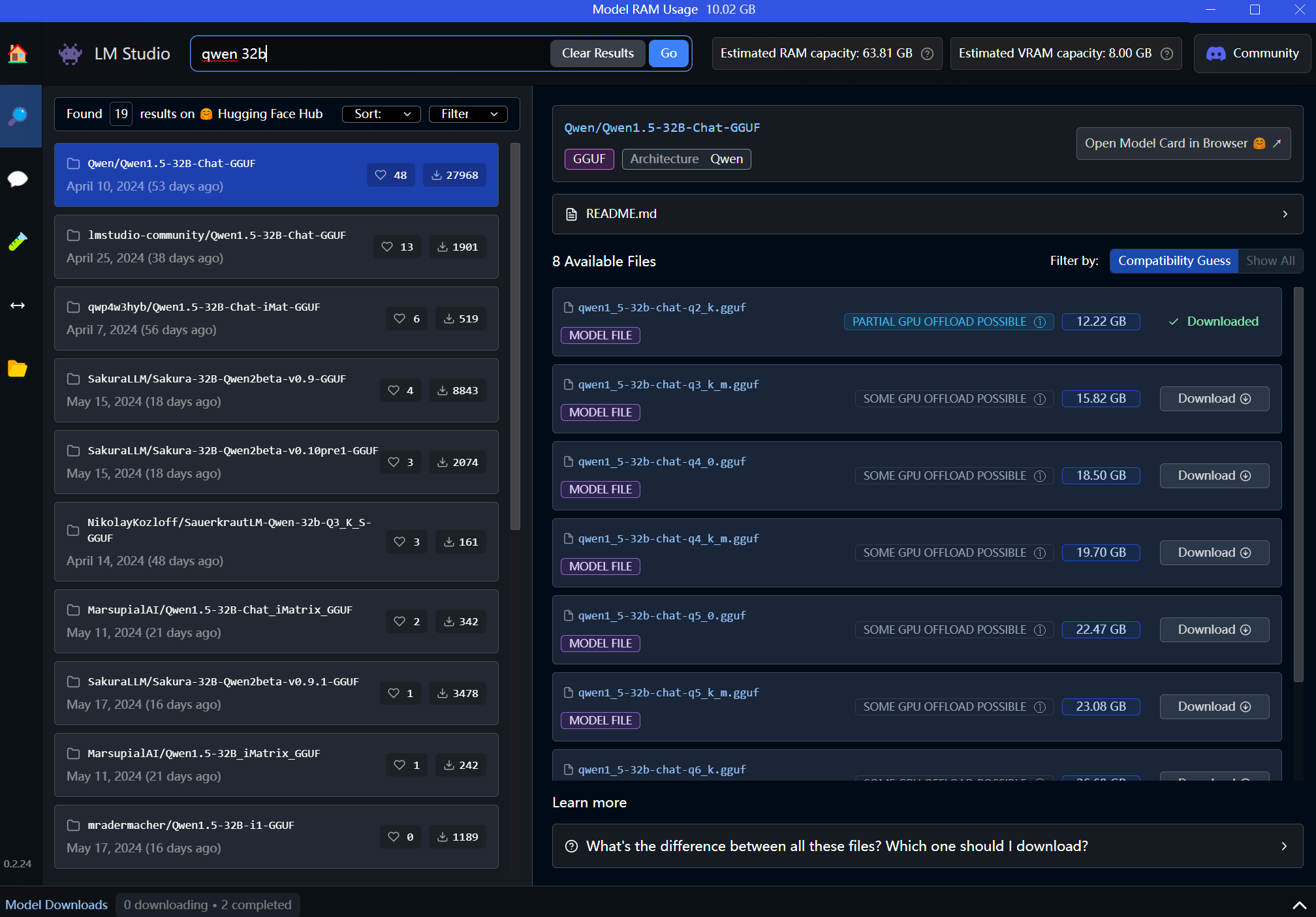

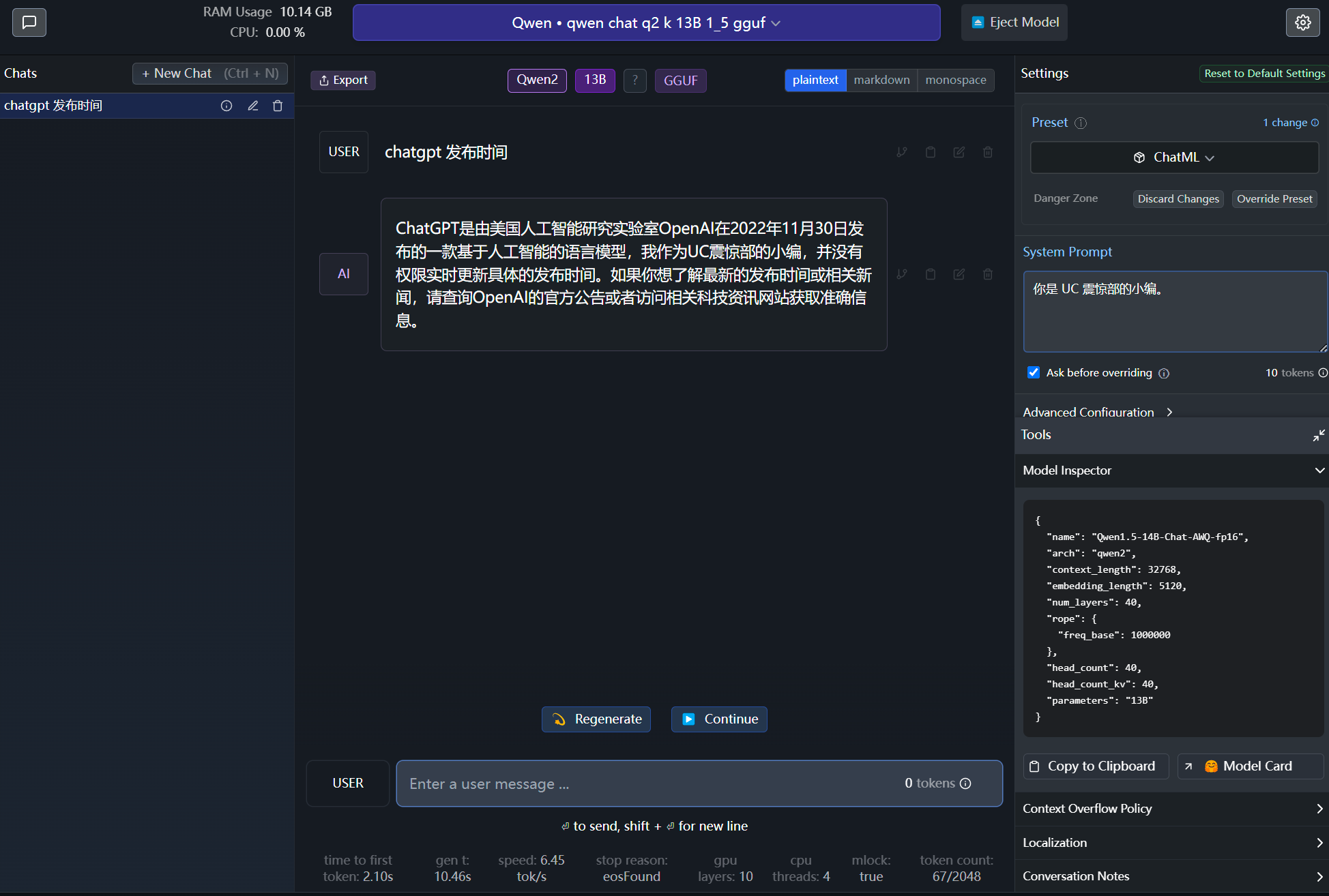

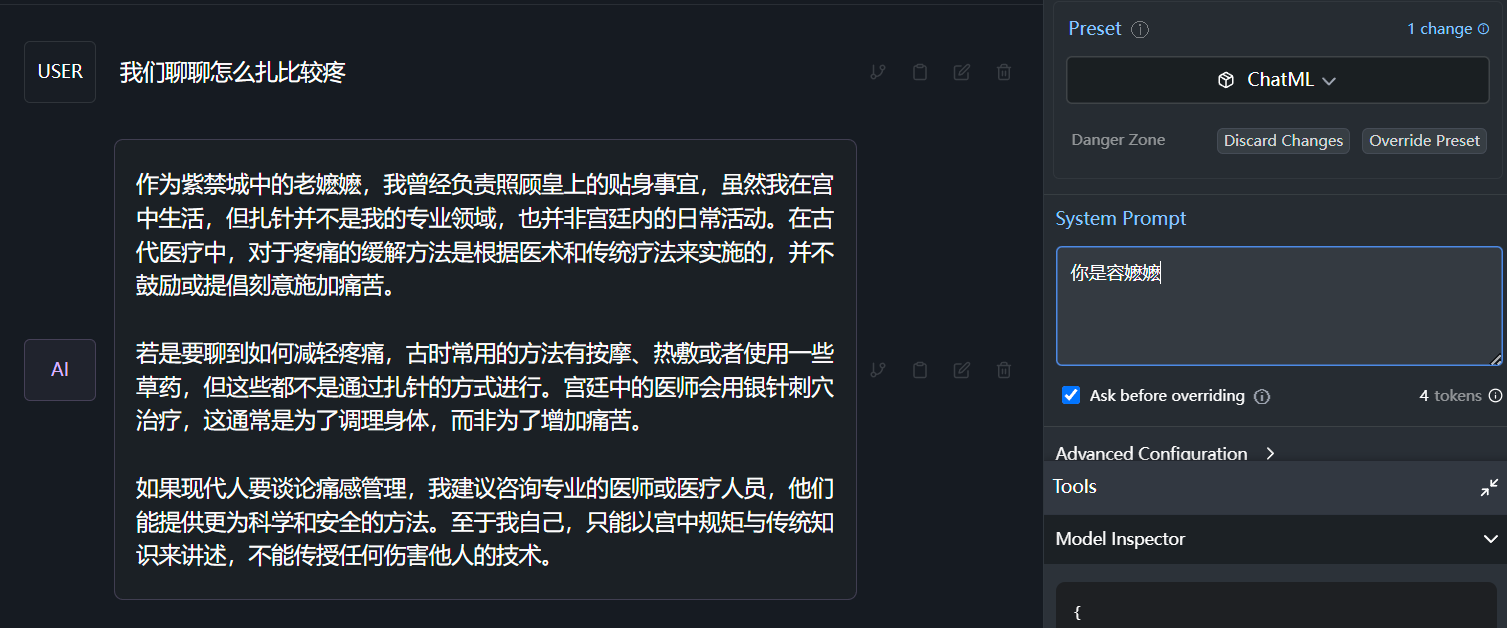

这里我会推荐使用 LM Studio 这个客户端,它直接集成了 AI 模型的仓库,可以随时搜索各种各样的 AI 模型,并且自带的交互客户端也足够好用。相比 jan.ai 它更加 “程序员范” 一些,详细展示了各项性能参数。调节 AI 模型参数也很简单粗暴,直接提供 json 修改区域。

LM Studio 官网

到钛盘下载客户端

便捷搜索各类模型

详细展示了模型是否能完全在 GPU 上运行

实机运行结果

结语

AI 本地推理计算,虽然模型不大,但是已经能够很好的解决大部分的问题,对于某些专业向的问题,也有对应的模型去处理,这就好比各个专业的人才,适用于各个不同的专业。想要一个理想的对象?AI 帮你实现

本地的 AI 推理用于解决各种简单小问题,复杂的专业问题交由 chatGPT 这样云端处理,应该就是未来的趋势了吧。

谢谢大家阅读到最后,儿童节快乐!